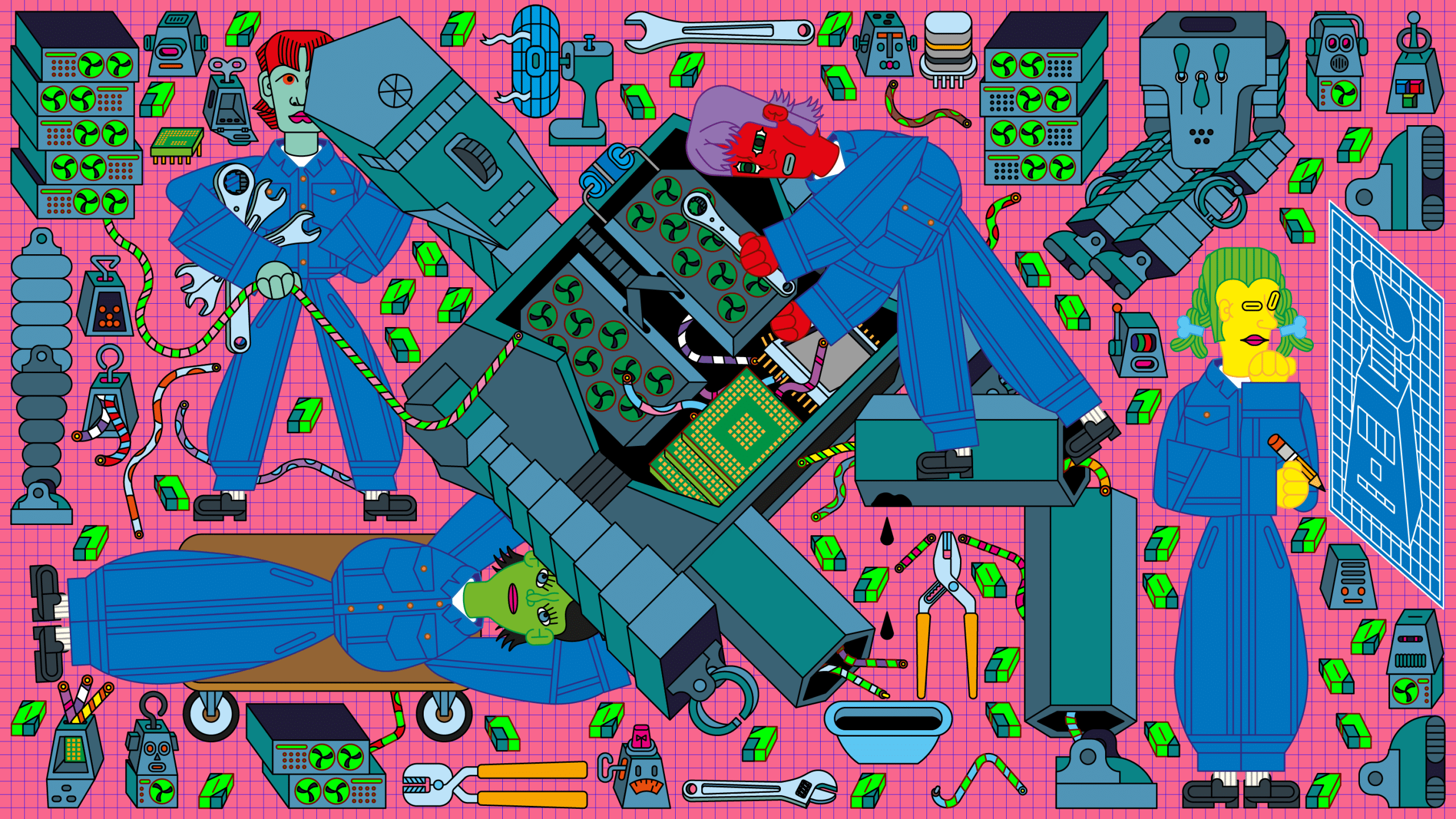

Сразу после инаугурации в январе, Президент Дональд Трамп анонсировал проект «Старгейт» — инициативу стоимостью $500 миллиардов, направленную на создание инфраструктуры искусственного интеллекта. Этот план, поддержанный крупнейшими технологическими гигантами, нацелен на ускоренное строительство массивных центров обработки данных и энергосетей по всей территории США, чтобы сохранить технологическое лидерство над Китаем.

Этот материал является частью серии публикаций «Энергоемкость: ИИ и наше энергетическое будущее» о потреблении энергии и углеродных расходах революции искусственного интеллекта.

Подход «любой ценой» в глобальной гонке доминирования в области ИИ стал главной темой обсуждений на Всемирном экономическом форуме в Давосе, как отмечает Ракель Уртасун, основатель и генеральный директор канадского стартапа по производству беспилотных грузовиков Waabi. Форум прошел одновременно с объявлением Трампа. «Я очень обеспокоена тем, куда движется отрасль», — заявляет Уртасун.

Она не одинока. «Инвестируются миллиарды, сжигаются графические процессоры, испаряется вода — это абсолютно неверное направление», — говорит Али Фархади, генеральный директор некоммерческого Института ИИ Аллена из Сиэтла.

Однако, если отвлечься от разговоров о растущих расходах и климатическом воздействии, можно найти поводы для оптимизма. Сейчас разрабатываются инновации, которые могут повысить эффективность как программного обеспечения, лежащего в основе моделей ИИ, так и компьютерных чипов, на которых эти модели работают, а также центров обработки данных, где чипы функционируют круглосуточно.

Вот что необходимо знать о потенциальном снижении энергопотребления и, соответственно, выбросов углерода во всех трех областях — а также дополнительный довод для осторожного оптимизма: есть основания полагать, что фундаментальные бизнес-реалии в конечном итоге склонятся в сторону более энергоэффективного ИИ.

1/ Более эффективные модели

Самое очевидное место для начала — это сами модели: то, как они создаются и как эксплуатируются.

Модели ИИ строятся путем обучения нейронных сетей на огромном количестве данных. Большие языковые модели обучаются на гигантских массивах текста, модели для самоуправляемых автомобилей — на огромном объеме данных о вождении и так далее.

Но сбор данных часто бывает бессистемным. Для обучения больших языковых моделей используются наборы данных, включающие тексты, собранные с большей части интернета, и огромные библиотеки оцифрованных книг. Практика заключалась в том, чтобы брать все, что можно найти, забрасывать в общую массу и смотреть, что получится. Такой подход, безусловно, сработал, но многократное обучение модели на гигантском наборе данных для самостоятельного извлечения релевантных закономерностей — это пустая трата времени и энергии.

Возможен ли более эффективный путь? От детей не ожидают, что они научатся чему-либо, просто прочитав все написанное; им дают сфокусированную учебную программу. Уртасун считает, что с ИИ нужно поступить аналогично: обучать модели на более кураторских данных, адаптированных под конкретные задачи. (Waabi обучает свои роботраки внутри сверхреалистичной симуляции, которая позволяет тонко настраивать виртуальные данные, предъявляемые моделям.)

Это не только Waabi. Стартап Writer, который создает большие языковые модели для корпоративных клиентов, утверждает, что их модели дешевле в обучении и эксплуатации, отчасти потому, что они используют синтетические данные. Подача моделям специально подготовленных наборов данных вместо более крупных, но менее курируемых, ускоряет процесс обучения (и, следовательно, снижает затраты). Например, вместо простого скачивания «Википедии», команда Writer берет отдельные страницы и переписывает их содержимое в разных форматах — например, как вопросы и ответы, а не сплошным текстом, — чтобы модели могли извлекать больше пользы из меньшего объема информации.

Обучение — это только начало жизненного цикла модели. По мере роста размеров моделей, их эксплуатация становится все дороже. Модели, использующие так называемое «рассуждение» (reasoning models), которые пошагово обрабатывают запрос перед выдачей ответа, особенно энергозатратны, поскольку они вычисляют серию промежуточных субответов для каждого конечного результата. Стоимость этих новых возможностей ошеломляет: по оценкам, запуск модели рассуждения o3 от OpenAI может стоить до $30 000 за задачу.

Однако эта технология существует всего несколько месяцев и до сих пор экспериментальна. Фархади ожидает, что эти затраты скоро снизятся. Например, инженеры найдут способы предотвратить уход моделей рассуждения слишком далеко по нежизнеспособному пути, прежде чем они поймут, что он бесперспективен. «Первый раз, когда вы что-то делаете, это намного дороже, а затем вы находите способ сделать это меньше и эффективнее», — говорит Фархади. «Это довольно устойчивый тренд в технологиях».

Один из способов добиться прироста производительности без значительного увеличения энергопотребления — это выполнять шаги инференса (вычисления, которые модель производит для получения ответа) параллельно, добавляет он. Параллельные вычисления лежат в основе многих современных программ, особенно больших языковых моделей (GPU по своей природе параллельны). Даже при этом основную технику можно применять к более широкому спектру задач. Разделяя задачу и выполняя разные ее части одновременно, параллельные вычисления могут быстрее давать результаты. Это также может экономить энергию за счет более эффективного использования доступного оборудования. Но это требует хитрых новых алгоритмов для координации множества подзадач и сведения их в единый результат в конце.

Самые крупные и мощные модели не будут использоваться постоянно. Много говорят о малых моделях — версиях больших языковых моделей, сжатых до карманного формата. Во многих случаях эти более эффективные модели работают не хуже более крупных, особенно для конкретных вариантов использования.

По мере того как компании осмысляют, как большие языковые модели вписываются/не вписываются в их потребности, этот тренд к более эффективным специализированным моделям набирает обороты. Вам не нужен универсальный LLM для управления запасами или ответа на узкоспециализированные запросы клиентов. «Будет очень, очень много специализированных моделей, а не одна «богоданная» модель, которая решает все», — утверждает Фархади.

Кристина Шим, директор по устойчивому развитию в IBM, видит этот тренд в том, как ее клиенты внедряют технологию. Она помогает бизнесу выбирать наименьшие и наименее энергоемкие модели. «Не только самая большая модель даст вам максимальную отдачу», — говорит она. Меньшая модель, которая делает именно то, что вам нужно, — лучшая инвестиция, чем большая, которая делает то же самое: «Давайте не будем использовать кувалду, чтобы забить гвоздь».

2/ Более эффективные компьютерные чипы

По мере оптимизации программного обеспечения, аппаратное обеспечение, на котором оно работает, также будет становиться более эффективным. Здесь наблюдается некоторое противоречие: в краткосрочной перспективе производители чипов, такие как Nvidia, стремятся разрабатывать все более мощные чипы, чтобы удовлетворить спрос компаний, желающих запускать все более мощные модели. Но в долгосрочной перспективе эта гонка не является устойчивой.

«Модели стали настолько большими, что даже выполнение этапа инференса становится серьезной проблемой», — говорит Навин Верма, соучредитель и генеральный директор стартапа EnCharge AI.

Такие компании, как Microsoft и OpenAI, теряют деньги на эксплуатации своих моделей в центрах обработки данных для удовлетворения спроса миллионов пользователей. Меньшие модели помогут. Другой вариант — перенести вычисления из дата-центров в собственные устройства пользователей.

Это то, что Microsoft пыталась сделать со своей инициативой Copilot+ PC, где они продвигали суперзаряженный ПК, позволяющий пользователю самостоятельно запускать модель ИИ (и покрывать счета за электроэнергию). Идея не получила массового распространения, но Верма считает, что этот вектор сохранится, поскольку компании захотят переложить на пользователей как можно больше расходов на эксплуатацию моделей.

Но чтобы ИИ-модели (даже небольшие) надежно работали на персональных устройствах, потребуется качественный скачок в эффективности чипов, которые обычно питают эти устройства. Эти чипы должны стать еще более энергоэффективными, поскольку они должны работать исключительно от аккумулятора, — объясняет Верма.

Здесь в игру вступает EnCharge. Их решение — это новый тип чипа, который отказывается от цифровых вычислений в пользу того, что называется аналоговыми вычислениями в памяти (analog in-memory computing). Вместо представления информации бинарными 0 и 1, как в электронике обычных цифровых компьютерных чипов, электроника в аналоговых чипах может представлять информацию в диапазоне значений между 0 и 1. Теоретически это позволяет выполнять больше работы при том же количестве энергии.

EnCharge была выделена из исследовательской лаборатории Вермы в Принстоне в 2022 году. «Мы десятилетиями знали, что аналоговые вычисления могут быть намного эффективнее — на порядки эффективнее — чем цифровые», — говорит Верма. Но аналоговые компьютеры никогда не работали хорошо на практике, потому что допускали много ошибок. Верма и его коллеги обнаружили способ проводить аналоговые вычисления, которые являются точными.

EnCharge концентрируется только на базовых вычислениях, требуемых ИИ сегодня. При поддержке таких полупроводниковых гигантов, как TSMC, стартап разрабатывает оборудование, которое выполняет матричное умножение высокой размерности (основная математика, лежащая в основе всех моделей глубокого обучения) на аналоговом чипе, а затем передает результат обратно окружающему цифровому компьютеру.

Оборудование EnCharge — лишь один из ряда экспериментальных новых дизайнов чипов на горизонте. IBM и другие уже много лет исследуют так называемые нейроморфные вычисления. Идея состоит в том, чтобы спроектировать компьютеры, имитирующие сверхэффективную мощность обработки мозга. Другой путь включает оптические чипы, которые заменяют электроны в традиционном чипе на свет, что опять же снижает энергию, необходимую для вычислений. Ни один из этих дизайнов пока не может конкурировать с электронными цифровыми чипами, производимыми такими компаниями, как Nvidia. Но по мере роста спроса на эффективность, такие альтернативы будут ждать своего часа.

Эффективнее можно сделать не только чипы. Большая часть энергии внутри компьютеров тратится на передачу данных туда и обратно. IBM заявляет, что разработала новый тип оптического переключателя, устройства, которое управляет цифровым трафиком, на 80% более эффективный, чем предыдущие переключатели.

3/ Более эффективное охлаждение в центрах обработки данных

Еще одним огромным источником спроса на энергию является необходимость управления отработочным теплом, выделяемым высокопроизводительным оборудованием, на котором работают модели ИИ. Том Ирп, технический директор проектной фирмы Page, строит дата-центры с 2006 года, включая шестилетнюю работу в Meta. Ирп ищет эффективность во всем: от структуры здания до электроснабжения, систем охлаждения и способа передачи данных внутрь и наружу.

В течение десятилетия или дольше, по мере замедления Закона Мура, дизайн дата-центров оставался довольно стабильным, — говорит Ирп. А потом все изменилось. С переходом на процессоры, такие как GPU, и появлением еще более новых дизайнов чипов, трудно предсказать, какое оборудование придется размещать в новом дата-центре в ближайшие годы — и, следовательно, какие энергетические нагрузки он должен будет поддерживать. Но в краткосрочной перспективе безопасная ставка — что чипы продолжат становиться быстрее и горячее: «Я вижу, что те, кто должен принимать эти решения, планируют значительный рост необходимой мощности», — отмечает Ирп.

Одно ясно: чипы, запускающие модели ИИ, например, GPU, требуют больше энергии на единицу площади, чем предыдущие типы компьютерных чипов. И это имеет серьезные последствия для инфраструктуры охлаждения внутри дата-центра. «Когда растет мощность, растет и тепло», — говорит Ирп.

При таком скоплении высокопроизводительных чипов воздушного охлаждения (проще говоря, больших вентиляторов) уже недостаточно. Вода стала предпочтительным хладагентом, поскольку она лучше воздуха отводит тепло. Это не очень хорошая новость для местных источников воды вокруг дата-центров. Но существуют способы сделать водяное охлаждение более эффективным.

Один из вариантов — использовать воду для отвода отработочного тепла из дата-центра в места, где его можно использовать. В Дании вода из дата-центров используется для отопления домов. В Париже во время Олимпиады ее использовали для нагрева бассейнов.

Вода также может служить своего рода аккумулятором. Энергия, генерируемая возобновляемыми источниками, такими как ветряные турбины или солнечные панели, может использоваться для охлаждения воды, которая затем хранится до тех пор, пока не понадобится для охлаждения компьютеров позже, что снижает пиковое потребление электроэнергии.

Но поскольку дата-центры становятся горячее, одного водяного охлаждения уже недостаточно, — говорит Тони Атти, генеральный директор Phononic, стартапа, поставляющего специализированные чипы охлаждения. Производители чипов создают чипы, которые перемещают данные все быстрее и быстрее. Он указывает на Nvidia, которая собирается выпустить чип, обрабатывающий 1,6 терабайта в секунду: «На такой скорости передачи данных начинается полный хаос, и спрос на охлаждение растет экспоненциально», — отмечает он.

По словам Атти, чипы внутри серверов потребляют около 45% энергии в дата-центре. Но охлаждение этих чипов теперь требует почти столько же энергии — около 40%. «Впервые управление тепловыми режимами становится сдерживающим фактором для расширения этой инфраструктуры ИИ», — заключает он.

Охлаждающие чипы Phononic — это небольшие термоэлектрические устройства, которые можно размещать на оборудовании, нуждающемся в охлаждении, или рядом с ним. Питание светодиодного чипа испускает фотоны; питание термоэлектрического чипа испускает фононы (которые относятся к колебательной энергии — то есть к температуре — так же, как фотоны к свету). Проще говоря, фононные чипы перемещают тепло с одной поверхности на другую.

Эти чипы, размещенные в тесных пространствах внутри серверов и вокруг них, могут обнаруживать незначительное повышение температуры и включаться или выключаться для поддержания стабильной температуры. Когда они включены, они отводят избыточное тепло в водопроводную трубу для удаления. Атти говорит, что их также можно использовать для повышения эффективности существующих систем охлаждения. Чем быстрее вы можете охладить воду в дата-центре, тем меньше ее потребуется.

4/ Сокращение затрат идет рука об руку с сокращением энергопотребления

Несмотря на взрывной рост энергопотребления ИИ, есть повод для оптимизма. Устойчивое развитие часто является второстепенным вопросом или приятным дополнением. Но в случае с ИИ лучший способ сократить общие затраты — это снизить счет за электроэнергию. Это хорошая новость, поскольку должно стимулировать компании повышать эффективность. «Я думаю, у нас есть совпадение между климатической устойчивостью и экономической устойчивостью», — говорит Верма. «Я думаю, в конечном счете это станет тем главным движущим фактором, который заставит отрасль стать более энергоэффективной».

Шим согласна: «Это просто хороший бизнес, понимаете?»

По ее словам, компании будут вынуждены тщательно обдумывать, как и когда они используют ИИ, выбирая меньшие, специализированные варианты, когда это возможно: «Просто посмотрите на мир сейчас. Расходы на технологии, как и на все остальное, будут еще более критичными в будущем».

Шим считает опасения по поводу энергопотребления ИИ обоснованными. Но она ссылается на бум интернета и персональных компьютеров, произошедший 25 лет назад. По мере совершенствования технологий, лежащих в основе этих революций, энергозатраты оставались примерно на одном уровне, хотя число пользователей резко возросло, отмечает она.

Это общий закон, который, по мнению Шим, сработает и на этот раз: когда технология созревает, она становится эффективнее. «Я думаю, сейчас мы находимся именно на этом этапе с ИИ».

ИИ быстро становится товаром, а это значит, что рыночная конкуренция будет снижать цены. Чтобы оставаться в игре, компании будут стремиться сократить энергопотребление ради собственной выгоды, если ни по какой другой причине.

В конечном счете, возможно, капитализм нас и спасет.